Che cos'è la sicurezza di rete del cloud?

La sicurezza di rete del cloud è un aspetto critico della salvaguardia delle applicazioni containerizzate e dei loro dati nel panorama del cloud computing moderno. Si tratta di mettere in sicurezza le comunicazioni e le configurazioni di rete per queste applicazioni, indipendentemente dalla piattaforma di orchestrazione in uso. La sicurezza di rete nel cloud affronta la segmentazione della rete, gli spazi dei nomi, le reti overlay, il filtraggio del traffico e la crittografia per i container. Implementando le tecnologie e le best practice per la sicurezza di rete nel cloud, le organizzazioni possono prevenire efficacemente gli attacchi basati sulla rete, come il cryptojacking, il ransomware e il BotNetC2, che possono avere un impatto sia sulle reti pubbliche che su quelle interne utilizzate dai container per lo scambio di dati.

Spiegazione della sicurezza di rete nel cloud

Tutti i carichi di lavoro vengono eseguiti sullo stesso stack di rete e sugli stessi protocolli, indipendentemente dal fatto che vengano eseguiti su server bare-metal, macchine virtuali o in container. In altre parole, i carichi di lavoro containerizzati sono soggetti a molti degli stessi attacchi basati sulla rete delle applicazioni legacy: cryptojacking, ransomware, BotNetC2 e altro ancora.

Le minacce alla sicurezza di rete, tuttavia, possono avere un impatto sui container in due modi: attraverso le reti pubbliche che collegano le applicazioni a Internet e attraverso le reti interne che i container Kubernetes utilizzano per scambiare dati tra loro.

La sicurezza di rete nel cloud si concentra sulla protezione delle comunicazioni e delle configurazioni di rete per le applicazioni containerizzate in generale, indipendentemente dalla piattaforma di orchestrazione. Affronta aspetti come la segmentazione della rete, i namespace, le reti overlay, il filtraggio del traffico e la crittografia per i container.

La sicurezza di rete di Kubernetes si rivolge alla sicurezza di rete all'interno di un cluster Kubernetes e comprende caratteristiche specifiche di Kubernetes, come le politiche di rete, i controlli di ingresso e di uscita, l'isolamento dello spazio dei nomi, il controllo degli accessi basato sui ruoli (RBAC) e l'implementazione della rete di servizi.

Il rilevamento di segnali di attività dannose su entrambi i tipi di rete richiede sia la sicurezza dei container che la sicurezza di rete di Kubernetes. Poiché si tratta di domini distinti, meritano discussioni separate per coprire i loro aspetti unici. In questa sezione, approfondiremo i vari aspetti della sicurezza di rete del cloud in relazione ai container e discuteremo le migliori pratiche per salvaguardare il suo ambiente.

Sicurezza di rete nel cloud

Una volta distribuiti, i container devono essere protetti dai tentativi di furto di dati proprietari e di risorse di calcolo. La sicurezza di rete del cloud limita in modo proattivo le comunicazioni indesiderate e impedisce alle minacce di attaccare le sue applicazioni una volta distribuite.

Firewall di nuova generazione in container, sicurezza delle applicazioni web e delle API (WAAS)e strumenti di microsegmentazione ispezionano e proteggono tutto il traffico in entrata e in uscita dai container (nord-sud ed est-ovest), garantendo una completa visibilità di livello 7e il controllo dell'ambiente Kubernetes. Inoltre, i firewall containerizzati scalano dinamicamente in base alle dimensioni e alle richieste in rapida evoluzione dell'infrastruttura container, per fornire sicurezza e larghezza di banda alle operazioni aziendali.

Segmentazione della rete

La segmentazione della rete è la pratica di dividere una rete in segmenti più piccoli e isolati per limitare l'accesso non autorizzato, contenere le minacce potenziali e migliorare le prestazioni complessive della rete. Negli ambienti containerizzati, i team addetti alla sicurezza possono ottenere la segmentazione della rete attraverso una serie di metodi.

Spazi dei nomi della rete

Gli spazi dei nomi di rete forniscono l'isolamento tra i contenitori, creando uno stack di rete separato per ciascuno di essi, comprese le proprie interfacce di rete, le tabelle di routing e le regole del firewall. Sfruttando i namespace di rete, può evitare che i container interferiscano con le configurazioni di rete degli altri e limitare la loro visibilità alle sole risorse di rete richieste.

Reti sovrapposte

Le reti overlay creano un livello di rete virtuale in cima alla rete fisica esistente, che consente ai container di comunicare tra host diversi come se fossero sulla stessa rete. Le soluzioni di rete overlay più diffuse per i container includono il driver overlay integrato di Docker, Flannel e Weave.

Partizioni di rete e gruppi di sicurezza

Le partizioni di rete e i gruppi di sicurezza possono segmentare ulteriormente le reti di container creando confini logici e applicando regole firewall specifiche per limitare il traffico tra i segmenti.

Filtro del traffico e regole del firewall

I firewall di nuova generazione containerizzati impediscono al malware di entrare e diffondersi all'interno del cluster, impedendo anche le connessioni malevole in uscita utilizzate per l'esfiltrazione dei dati e gli attacchi di comando e controllo (C2). Sebbene gli strumenti di sicurezza shift-left forniscano una protezione in tempo di distribuzione contro le vulnerabilità note, i firewall di nuova generazione containerizzati offrono protezione contro le vulnerabilità sconosciute e non patchate.

Il filtraggio del traffico e le regole del firewall sono essenziali per controllare il flusso di traffico tra i container, così come tra i container e l'host.

Filtraggio in entrata e in uscita

Il filtraggio in entrata controlla il traffico in uscita da un contenitore, mentre il filtraggio in uscita controlla il traffico in entrata verso un contenitore. Applicando il filtraggio in entrata e in uscita, può limitare l'esposizione dei suoi container alle minacce esterne e limitare la loro comunicazione solo ai servizi necessari.

Applicazione delle regole del firewall al traffico dei container

Le regole del firewall possono essere applicate a vari livelli, tra cui il livello host, container e rete. Può utilizzare iptables o firewalld di Linux, ad esempio, per creare regole che governano il traffico dei container e proteggere la sua infrastruttura da accessi non autorizzati e attività dannose.

Bilanciamento del carico e instradamento del traffico

Il bilanciamento del carico e l'instradamento del traffico sono importanti per distribuire il traffico su più container e garantire l'alta disponibilità delle sue applicazioni. Soluzioni come HAProxy, NGINX o i servizi integrati di Kubernetes possono essere utilizzati per instradare il traffico verso il contenitore appropriato, in base a regole predefinite e controlli di salute.

Crittografia e comunicazione sicura

La crittografia e la sicurezza delle comunicazioni tra i container, e tra i container e l'host, è fondamentale per proteggere i dati sensibili e mantenere l'integrità delle sue applicazioni.

Sicurezza del livello di trasporto (TLS) per il traffico dei container.

TLS fornisce la crittografia e l'autenticazione dei dati trasmessi in rete. Implementando TLS per il traffico dei container, può garantire che i dati trasmessi tra i container e tra i container e l'host siano crittografati e sicuri da intercettazioni o manomissioni. Può ottenere questo risultato utilizzando strumenti come OpenSSL o Let's Encrypt per generare e gestire i certificati TLS per i suoi container.

Protezione della comunicazione da contenitore a contenitore

Per proteggere la comunicazione tra i contenitori, può utilizzare soluzioni native del contenitore, come le reti crittografate integrate di Docker, o strumenti di terze parti come Cilium, che offre una sicurezza di rete API-aware per i contenitori. Queste soluzioni le consentono di implementare la crittografia, l'autenticazione e l'autorizzazione per il traffico da contenitore a contenitore.

Protezione della comunicazione tra contenitore e host

Per garantire una comunicazione sicura tra i container e l'host, si può utilizzare la crittografia a livello di host e i meccanismi di autenticazione, come le API protette da SSH o TLS, per controllare l'accesso alle interfacce di gestione dei container e ai sistemi di archiviazione dei dati.

Sicurezza di rete di Kubernetes

Politiche di rete

Le politiche di rete sono una caratteristica chiave di Kubernetes che le consente di controllare il flusso di traffico all'interno del cluster e tra il cluster e le reti esterne. Gli strumenti moderni consentono ai team addetti alla sicurezza di definire politiche che determinano essenzialmente chi e cosa può accedere a un determinato microservizio. Le organizzazioni hanno bisogno di un quadro per definire queste politiche e assicurarsi che siano mantenute in modo coerente in un ambiente di applicazioni container altamente distribuito.

Definire e applicare le politiche di rete.

Le politiche di rete di Kubernetes sono definite mediante file YAML, che specificano il traffico consentito tra componenti come pod, servizi e spazi dei nomi. Una volta definite, queste politiche possono essere applicate utilizzando i plugin di rete che supportano l'API delle politiche di rete di Kubernetes, come Calico o Cilium.

Whitelisting e blacklisting del traffico

Le politiche di rete possono essere utilizzate per inserire nella whitelist o nella blacklist il traffico tra i componenti del suo cluster, in base a criteri che includono le etichette dei pod, gli indirizzi IP o i namespace. Stabilendo queste regole, potrà controllare quali servizi possono comunicare tra loro e impedire l'accesso non autorizzato a dati o risorse sensibili.

Isolamento e segmentazione dello spazio dei nomi

Applicando le politiche di rete a livello di namespace, può isolare e segmentare le applicazioni o gli ambienti all'interno del suo cluster, limitando il traffico solo ai componenti necessari e prevenendo potenziali rischi di rete.

Controlli di ingresso e di uscita

Il controllo del traffico in entrata e in uscita è fondamentale per gestire il flusso di dati in entrata e in uscita dal cluster Kubernetes e per proteggerlo dalle minacce esterne.

Controllori di ingresso e bilanciamento del carico

I controller di ingresso in Kubernetes gestiscono l'instradamento del traffico esterno verso i servizi appropriati all'interno del cluster, in base a regole predefinite. Il bilanciamento del carico può essere ottenuto attraverso servizi Kubernetes integrati o soluzioni di terze parti come NGINX e HAProxy. Queste soluzioni le permettono di instradare il traffico in base a criteri come il percorso, l'host o le intestazioni. Le consentono anche di fornire la terminazione TLS e altre funzioni di sicurezza.

Migliori pratiche per l'accesso in entrata

- Correggere la politica predefinita di Kubernetes "any-any-any allow" applicando una politica deny-all per ogni spazio dei nomi.

- Impedisce ai servizi di accettare il traffico in entrata direttamente da IP esterni, a meno che non sia collegato un bilanciatore di carico o un ingress. Consente solo il traffico in entrata da load-balancer o ingress.

- Limita il traffico a protocolli e porte specifiche in base ai requisiti del servizio (ad esempio, HTTP/HTTPS per i servizi web, UDP 53 per il servizio DNS).

- Accettano il traffico solo da altri servizi (pod) che li consumano, sia nello stesso spazio dei nomi che da un altro.

- Per creare una politica di ingresso da un pod in un altro spazio dei nomi, aggiunga un'etichetta allo spazio dei nomi.

Gestione del traffico in uscita

Il controllo del traffico in uscita dal cluster Kubernetes è essenziale per evitare la perdita di dati e per garantire che le connessioni in uscita siano limitate solo alle destinazioni richieste. Può ottenere questo risultato utilizzando le politiche di rete in uscita, che le permettono di definire le regole per il traffico in uscita dai suoi pod o namespace. Inoltre, si possono utilizzare gateway di uscita o soluzioni proxy come Squid per controllare e monitorare il traffico in uscita dal cluster.

Migliori pratiche per l'accesso in uscita

- Comprenda la necessità di ogni servizio esterno utilizzato dai suoi microservizi. Prodotti come Prisma Cloud Compute Defender possono aiutare a identificare i flussi esterni impegnati dai microservizi.

- Se un pod deve connettersi a un nome DNS (FQDN) senza un indirizzo IP fisso, utilizzi un firewall esterno o un proxy, poiché le politiche di rete di Kubernetes supportano solo gli indirizzi IP.

- Impedisca il traffico in uscita dai pod che non necessitano di connessioni esterne per ridurre il rischio di esfiltrazione dei dati o di download di file binari dannosi.

- Applichi un criterio di blocco dell'uscita se non ha dipendenze esterne, ma si assicuri che i servizi essenziali come Kubernetes DNS Service rimangano connessi quando applica i criteri di uscita.

La microsegmentazione basata su identità aiuta a limitare la comunicazione tra le applicazioni a livello 3 e 4, mentre i firewall containerizzati di prossima generazione eseguono l'ispezione profonda dei pacchetti di livello 7 e scansionano tutto il traffico consentito per identificare e prevenire le minacce note e sconosciute.

Politiche e sicurezza DNS

Il DNS è parte integrante della rete Kubernetes, in quanto fornisce la risoluzione dei nomi per i servizi e altri componenti all'interno del cluster. Garantisca la sicurezza e l'integrità della sua infrastruttura DNS per prevenire attacchi come DNS spoofing o cache poisoning.

Kubernetes fornisce politiche DNS integrate per controllare il comportamento della risoluzione DNS all'interno del suo cluster, e può anche utilizzare fornitori DNS esterni o soluzioni di sicurezza DNS come DNSSec per migliorare la sicurezza della sua infrastruttura DNS.

Rete di servizi e crittografia di rete

Il Service Mesh è un livello di infrastruttura dedicato che offre funzioni di rete avanzate, come il routing del traffico, il bilanciamento del carico e la sicurezza di rete per i suoi microservizi e le sue applicazioni containerizzate.

Implementazione del servizio Mesh

Soluzioni di service mesh come Istio e Linkerd possono essere integrate con il cluster Kubernetes per fornire funzionalità di rete avanzate e migliorare la sicurezza delle applicazioni containerizzate. Queste soluzioni offrono funzioni come il TLS reciproco, il controllo degli accessi e la crittografia del traffico, che possono aiutare a proteggere le sue applicazioni, in particolare i microservizi, da varie minacce alla sicurezza.

Mutual TLS (mTLS) per la comunicazione sicura

Mutual TLS (mTLS) è un protocollo di sicurezza in cui sia il client che il server si autenticano reciprocamente prima di stabilire una connessione sicura. A differenza del TLS tradizionale, in cui solo il server viene autenticato dal cliente, mTLS aggiunge un ulteriore livello di sicurezza, richiedendo al cliente di presentare un certificato. Il requisito aggiuntivo verifica che entrambe le parti siano chi dichiarano, il che può aiutare a prevenire accessi non autorizzati, fughe di dati e attacchi man-in-the-middle.

Osservabilità e controllo del traffico di rete.

Le soluzioni Service Mesh offrono anche l'osservabilità e il controllo del traffico di rete, consentendole di monitorare le prestazioni e la sicurezza delle sue applicazioni in tempo quasi reale. L'identificazione precoce di accessi non autorizzati, di modelli di traffico insoliti e di altri potenziali problemi di sicurezza significa che può intraprendere tempestivamente azioni correttive per mitigare i rischi.

Crittografia del traffico e dei dati sensibili

Per garantire la riservatezza e l'integrità dei dati all'interno del suo cluster, è essenziale implementare tecniche di crittografia per le comunicazioni interne ed esterne.

IPsec per crittografare le comunicazioni tra gli host

IPsec protegge il traffico del cluster crittografando le comunicazioni tra tutti gli host master e i nodi. Tenga presente l'overhead di IPsec e faccia riferimento alla documentazione dell'orchestrazione di container per abilitare le comunicazioni IPsec all'interno del cluster. Importi i certificati necessari nel database dei certificati pertinente e crei un criterio per proteggere la comunicazione tra gli host del suo cluster.

Configurazione dell'unità massima di trasmissione (MTU) per l'overhead IPsec

Regoli l'MTU del percorso o della commutazione per accogliere l'overhead dell'intestazione IPsec. Ad esempio, se il cluster opera su una rete Ethernet con un'unità di trasmissione massima (MTU) di 1500 byte, modifichi il valore MTU SDN per tenere conto dell'overhead dell'incapsulamento IPsec e SDN.

Abilitazione del TLS per la comunicazione API nel cluster

Kubernetes presuppone che la comunicazione API all'interno del cluster sia crittografata per impostazione predefinita utilizzando TLS. La maggior parte dei metodi di installazione crea e distribuisce i certificati necessari ai componenti del cluster. Tenga presente, però, che alcuni componenti e metodi di installazione possono abilitare le porte locali su HTTP. Gli amministratori devono rimanere informati sulle impostazioni di ogni componente per identificare e risolvere il traffico potenzialmente insicuro.

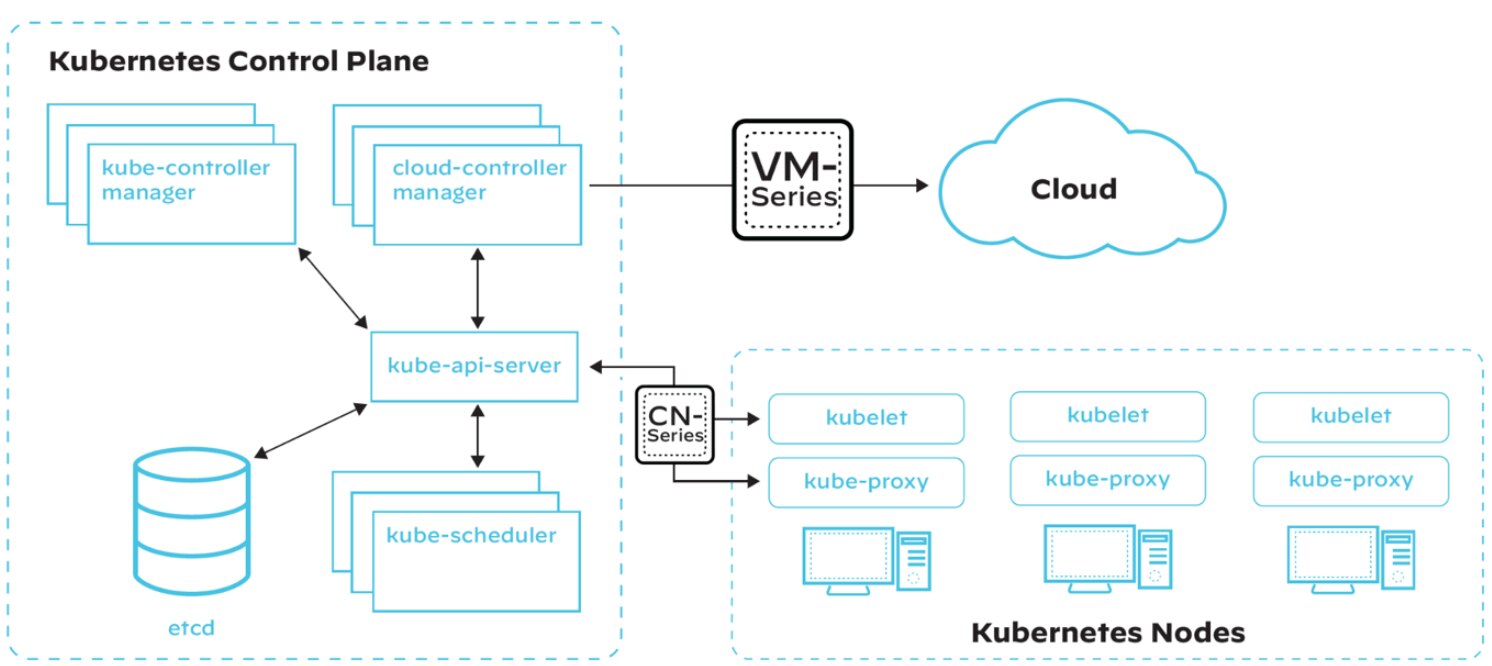

Sicurezza del piano di controllo di Kubernetes

I piani di controllo, in particolare nei cluster Kubernetes, sono obiettivi primari per gli attacchi. Per migliorare la sicurezza, rafforzi i seguenti componenti attraverso l'ispezione e la corretta configurazione:

- Nodi e loro perimetri

- Nodi master

- Componenti principali

- API

- Pods rivolti al pubblico

Sebbene la configurazione predefinita di Kubernetes offra un certo livello di sicurezza, l'adozione di best practice può rafforzare il cluster per i carichi di lavoro e la comunicazione runtime.

Politiche di rete (regole del firewall)

La rete piatta di Kubernetes consente a tutte le distribuzioni di raggiungere altre distribuzioni per impostazione predefinita, anche attraverso gli spazi dei nomi. Questa mancanza di isolamento tra i pod significa che un carico di lavoro compromesso potrebbe avviare un attacco ad altri componenti della rete. L'implementazione di politiche di rete può fornire isolamento e sicurezza.

Politica di sicurezza del Pod

Kubernetes consente ai pod di funzionare con diverse configurazioni non sicure per impostazione predefinita. Ad esempio, l'esecuzione di container privilegiati con permessi di root sull'host è ad alto rischio, così come l'utilizzo dei namespace e del file system dell'host o la condivisione della rete dell'host. Le politiche di sicurezza dei pod consentono agli amministratori di limitare i privilegi e i permessi di un pod prima di consentire la distribuzione nel cluster. Isolare i pod non dipendenti dal parlare tra loro utilizzando le politiche di rete aiuterà a prevenire il movimento laterale tra i container in caso di violazione.

Crittografia dei segreti

Le distribuzioni di base di Kubernetes non criptano i segreti a riposo per impostazione predefinita (anche se i servizi gestiti come GKE lo fanno). Se un aggressore ottiene l'accesso all'archivio di valori-chiave (in genere Etcd), può accedere a tutto ciò che si trova nel cluster, compresi i segreti non crittografati. La crittografia dell'archivio di stato del cluster protegge il cluster dall'esfiltrazione dei dati a riposo.

Controllo dell'accesso basato sui ruoli

Anche se RBAC non è esclusivo di Kubernetes, deve essere configurato correttamente per evitare la compromissione del cluster. RBAC consente un controllo granulare sui componenti del cluster a cui un pod o un utente può accedere. Limitando gli utenti e i pod che possono visualizzare, aggiornare, cancellare e creare all'interno del cluster, RBAC aiuta a limitare i danni potenziali di una compromissione.

Affrontare la sicurezza del piano di controllo attraverso il patching virtuale

Ridurre al minimo l'accesso a livello di amministratore ai piani di controllo e assicurarsi che il suo server API non sia esposto pubblicamente sono le basi di sicurezza più importanti.

I team DevOps e SecOps possono identificare le vulnerabilità nei pacchetti di applicazioni, ma mitigare questi rischi richiede tempo. I pacchetti vulnerabili devono essere sostituiti o patchati e testati prima della distribuzione, il che lascia l'ambiente esposto fino alla risoluzione del problema. Soluzioni come Prisma Cloud automatizzano la mappatura delle vulnerabilità per ogni carico di lavoro, per fornire patch virtuali per le vulnerabilità conosciute. Utilizzando il suo componente WAAS , la soluzione regola le politiche di ispezione del traffico per rilevare e bloccare gli exploit remoti basati su HTTP.

Migliori pratiche di sicurezza di rete per Container e Kubernetes

Riassumendo le aree discusse, le seguenti best practice servono come lista di controllo per garantire che i suoi team siano attrezzati per salvaguardare le applicazioni e i dati containerizzati dalle minacce basate sulla rete.

Monitoraggio e registrazione del traffico di rete

Tenere sotto controllo il traffico di rete è fondamentale per rilevare e rispondere agli incidenti di sicurezza e mantenere la salute generale del suo ambiente containerizzato.

Soluzioni di registrazione e monitoraggio centralizzate.

L'implementazione di una soluzione centralizzata di registrazione e monitoraggio per il suo ambiente container e Kubernetes, come ELK Stack, Prometheus o Prisma Cloud, può aiutarla a raccogliere, analizzare e visualizzare i dati del traffico di rete da diverse aree. Il facile accesso a dati intel centralizzati le consentirà di identificare le tendenze, rilevare le anomalie e ottenere approfondimenti sulle prestazioni e sulla sicurezza della sua infrastruttura.

Rilevare e rispondere agli incidenti di sicurezza

Il monitoraggio del traffico di rete e la creazione di avvisi per attività insolite o sospette consentono di individuare e rispondere rapidamente agli incidenti che comportano accesso non autorizzato, esfiltrazione di dati e altre attività dannose. I team addetti alla sicurezza sono in grado di adottare misure appropriate, come l'isolamento dei componenti interessati, il blocco degli IP dannosi o l'aggiornamento delle regole del firewall in modo tempestivo.

Visualizzazione e analisi del traffico di rete

La visualizzazione e l'analisi dei dati sul traffico di rete possono aiutarla a identificare modelli e tendenze che possono indicare potenziali rischi per la sicurezza di rete. Strumenti come Kibana, Grafana o dashboard personalizzati possono essere utilizzati per creare rappresentazioni visive del traffico di rete, consentendo di individuare anomalie e di indagare in modo più efficace sugli incidenti di sicurezza di rete.

Configurazioni di rete sicure

L'irrigidimento delle configurazioni di rete e l'implementazione di forti controlli di accesso sono fondamentali per proteggere il suo ambiente container e Kubernetes dalle minacce alla sicurezza.

Protezione delle impostazioni di rete dell'host e del cloud

Per mantenere la sicurezza del suo ambiente è necessario garantire configurazioni di rete sicure sia per l'host del container che per i singoli container. Le misure essenziali comprendono la disattivazione dei servizi di rete inutilizzati, la limitazione dell'accesso alla rete solo ai componenti necessari e l'applicazione di patch e aggiornamenti di sicurezza al sistema operativo host e al runtime del container.

Controlli di accesso alla rete e autenticazione

Per evitare accessi non autorizzati e mantenere l'integrità del suo ambiente container e Kubernetes, è essenziale implementare forti controlli di accesso e meccanismi di autenticazione. Le misure chiave prevedono l'utilizzo del controllo degli accessi basato sui ruoli (RBAC) per la gestione delle autorizzazioni degli utenti in Kubernetes, l'incorporazione dell'autenticazione a più fattori (MFA) e l'impiego di soluzioni di sicurezza di rete, come VPN o firewall, per limitare l'accesso al suo ambiente.

Valutazioni regolari della sicurezza di rete.

Valutazioni regolari della sicurezza di rete - scansioni di vulnerabilità, test di penetrazione e audit di sicurezza - sono un must quando si tratta di identificare potenziali punti deboli nel suo ambiente container e Kubernetes. Gli aspetti chiave di queste valutazioni riguardano l'esame delle configurazioni di rete, delle regole del firewall e delle politiche di sicurezza per garantire l'aderenza alle best practice del settore e ai requisiti di conformità.

Seguendo queste best practice e implementando misure di sicurezza di rete efficaci, può proteggere il suo ambiente container e Kubernetes da potenziali minacce basate sulla rete e garantire la sicurezza e l'integrità delle sue applicazioni e dei suoi dati.

FAQ sulla sicurezza di rete nel cloud

MTU, o unità massima di trasmissione, si riferisce alla dimensione massima di un pacchetto di dati che può essere trasmesso su una rete. È un parametro che contribuisce a determinare l'efficienza e le prestazioni della comunicazione di dati attraverso le reti. Il protocollo di controllo della trasmissione (TCP) utilizza l'MTU per determinare la dimensione massima di ciascun pacchetto nelle trasmissioni Internet.

Per adattarsi all'overhead aggiuntivo dell'intestazione introdotto dalla crittografia e dall'incapsulamento, è necessario regolare il valore MTU quando si utilizza IPsec per una comunicazione sicura. Ad esempio, se il cluster Kubernetes opera su una rete Ethernet con un MTU predefinito di 1500 byte, il valore MTU deve essere ridotto per tenere conto dell'overhead dell'incapsulamento IPsec e SDN. La regolazione impedisce la frammentazione dei pacchetti e garantisce una trasmissione dei dati più efficiente e sicura.